O Paradoxo das LLMs de Pequeno Porte: Visão Futurística ou Realidade Atual?

Chegamos a um ponto crucial no desenvolvimento da IA generativa, onde a questão não é mais se esses modelos se tornarão comuns, mas como serão utilizados. Assim como os modelos de aprendizado de máquina que precederam, a IA generativa está migrando para o offline e para a borda. Se antes investíamos em grandes infraestruturas na nuvem, agora vemos hardwares capazes de rodar esses modelos localmente, transformando a computação de borda em uma alternativa viável às arquiteturas tradicionais de big data.

Nos últimos anos, muitos têm tratado dispositivos inteligentes como meros terminais que necessitam da nuvem para executar funções complexas. Precisamos mudar essa visão e começar a considerar esses dispositivos como entidades autônomas com capacidade de decisão própria. Ao permitir que dispositivos façam processamento local, reduzimos a dependência da nuvem, diminuindo a superfície de ataque e aumentando a privacidade dos usuários.

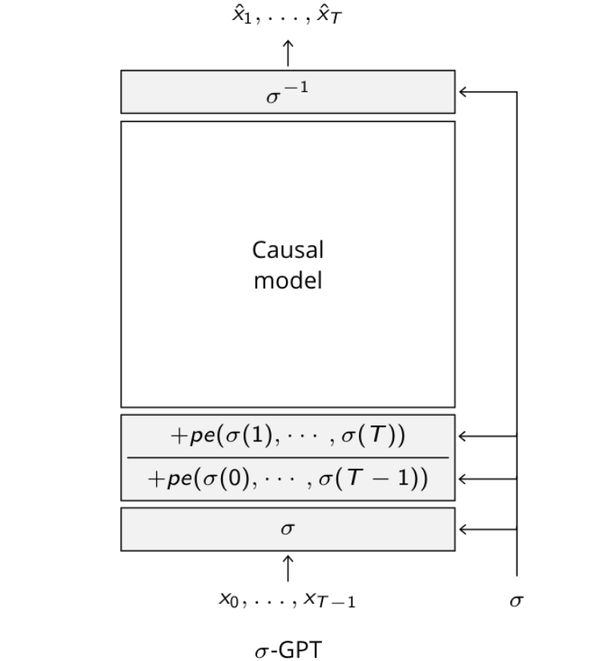

Embora a IA generativa, em geral, precise dos recursos da nuvem, há avanços significativos permitindo que modelos como o LLaMa sejam rodados em hardwares menos potentes. Técnicas como a quantização de quatro bits estão tornando possível a operação desses modelos em dispositivos simples, como um Raspberry Pi, ampliando a privacidade e a eficiência de processamento ao descentralizar a tomada de decisões.

A implementação de modelos LLM diretamente em dispositivos móveis, como o modelo Gemini Nano do Google para detectar chamadas de spam offline, indica que estamos no caminho certo. Arquiteturas híbridas que utilizam tinyML para acionar modelos LLM mais intensivos estão abrindo novas possibilidades. Esses gatilhos reduzem substancialmente o trabalho dos LLMs, permitindo que funcionem eficientemente em hardwares mais limitados.

O desejo de rodar modelos LLM localmente é uma clara demanda da comunidade de tecnologia, evidenciada pelo sucesso de projetos como Ollama, GPT4All e llama.cpp. Para uma trajetória ética, que proporciona interfaces mais intuitivas para interações do mundo real, é evidente que a privacidade e a descentralização são essenciais.

A visão de dispositivos inteligentes como simples extensões de software conectadas à nuvem tem limitado seu verdadeiro potencial de inovação. Precisamos reconsiderar essa abordagem e investir em tornar esses dispositivos realmente inteligentes, com capacidade de processamento e tomada de decisão local. Isso permitirá uma integração mais intuitiva e segura, alinhada às necessidades dos usuários.

A adoção de IA de pequeno porte é um passo nessa direção, onde modelos "open source" e acessíveis são fundamentais. Com eles, promovemos uma abordagem centrada na privacidade e que facilita o desenvolvimento local, evitando os maiores obstáculos éticos e de segurança que surgem com a centralização de dados.

É importante que a otimização dos LLMs para operar nestes ambientes mais contidos continue, permitindo uma experiência mais segura e eficiente sem sacrificar a capacidade funcional dos dispositivos. Talentosos profissionais e entusiastas têm um papel crítico nesse avanço, contribuindo para construir um futuro em que a tecnologia serve melhor o usuário final.

Conclusão:

Para um futuro ético e inovador nas áreas de AI, IoT e outras tecnologias emergentes, é necessário adotar a IA de pequeno porte e investir em soluções abertas e descentralizadas. Isso não apenas melhora a experiência do usuário, mas também protege seus dados, garantindo um futuro tecnológico mais seguro e eficiente.