O Risco Oculto da IA: Quando a Produção de Conteúdo se Torna uma Ameaça

A inteligência artificial está revolucionando a forma como criamos e consumimos conteúdo, mas uma ameaça oculta pode estar se escondendo nos bastidores. À medida que as IAs geram cada vez mais texto e imagem, há um risco de que esses dados sejam utilizados para treinar futuras IAs, levando a resultados piores e menos diversificados. Descubra como isso pode afetar a qualidade e a utilidade das IAs e o que pode ser feito para mitigar esse problema.

Quando a IA Começa a Treinar a Si Mesma

Hoje em dia, a internet está cheia de textos e imagens gerados por inteligência artificial. O CEO da OpenAI, Sam Altman, afirmou em fevereiro que a empresa estava criando cerca de 100 bilhões de palavras por dia – o equivalente a um milhão de romances diários. Essas palavras geradas por IA podem aparecer em avaliações de restaurantes, perfis de namoro ou postagens em redes sociais. Mas também podem surgir como artigos de notícias, como foi observado pelo grupo NewsGuard, que identificou mais de mil sites publicando notícias geradas por IA, muitas vezes com erros.

O grande problema é que, à medida que as IAs procuram novos dados na internet para treinar seus modelos, essas informações geradas por elas mesmas podem ser utilizadas. Isso cria um ciclo perigoso onde os dados gerados por uma IA treinam as futuras IAs, o que pode levar a resultados cada vez piores.

Por que isso é um problema?

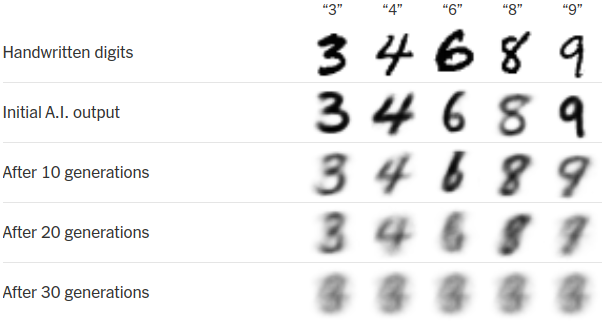

Quando uma IA é treinada usando dados gerados por outras IAs, a qualidade do resultado tende a piorar. Imagine uma IA que desenha números à mão. No início, os números saem nitidamente, mas se essa IA for treinada repetidamente com desenhos anteriores que ela mesma gerou, os números começariam a ficar borrados e, eventualmente, todos se pareceriam com uma única forma indistinguível.

Imagine agora um chatbot médico que, depois de várias gerações de treinamentos, começa a oferecer cada vez menos diagnósticos, porque foi treinado com um conjunto de dados mais limitado gerado por outros chatbots. Ou um professor de história digital que não consegue mais diferenciar fato de ficção, porque foi treinado com informações distorcidas geradas por IA.

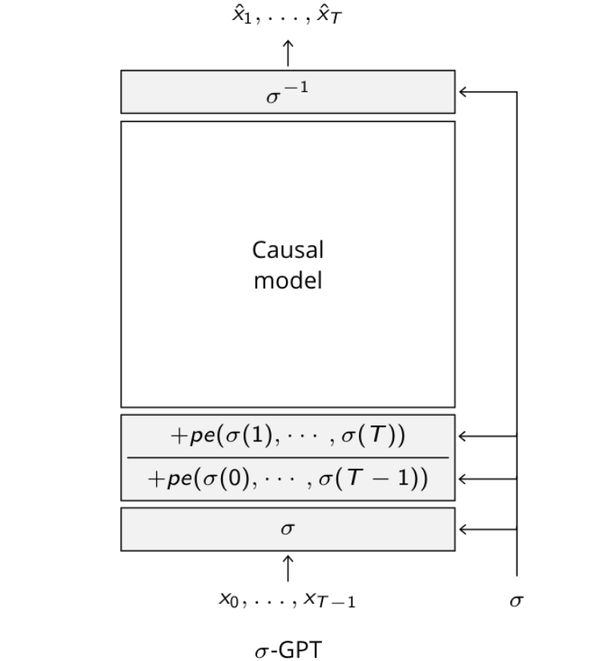

Se uma IA for continuamente treinada em cima de seus próprios resultados, ela começará a se afastar da realidade e seu desempenho se tornará cada vez mais ruim. Esse fenômeno é chamado de “colapso do modelo”, que ocorre quando a IA perde diversidade em suas respostas e começa a produzir saídas altamente semelhantes e de menor qualidade.

O que pode ser feito?

Existem algumas formas de mitigar esse problema. Uma delas seria usar sempre dados novos e reais para treinar os modelos de IA. Outra abordagem seria desenvolver melhores maneiras de identificar quando um conteúdo foi gerado por uma IA, por exemplo, usando marcas d'água digitais.

No entanto, o maior desafio talvez seja a necessidade de se garantir que os dados usados para treinar as IAs sejam de alta qualidade e diversos, o que pode requerer um esforço significativo, incluindo a compra de dados de fontes confiáveis.

Em resumo, enquanto a tecnologia de geração de conteúdo por Inteligência Artificial continua a avançar, enfrentar os desafios relacionados à qualidade e à diversidade dos dados será crucial para manter a eficácia e a utilidade dessas IAs.

Texto baseado em um artigo de Aatish Bhatia publicado no The New York Times.